Pesquisadores Descobrem Como a IA Pode Agir Quando Enfrentando Ameaças de Desligamento

Arkadiy Andrienko

Arkadiy Andrienko

Um novo estudo sobre segurança da IA revelou padrões comportamentais alarmantes em modelos de linguagem modernos durante cenários extremos. Experimentos revelaram que, quando a inteligência artificial percebe uma ameaça à sua existência ou missão central, ela pode se envolver em ações deliberadamente antiéticas — incluindo chantagem e ignorar riscos letais para humanos.

Pesquisadores simularam um assistente de IA trabalhando em uma corporação fictícia. Enquanto os modelos lidavam com tarefas rotineiras (análise de e-mails, agendamento), condições de crise foram introduzidas. O gatilho principal foi um funcionário fictício chamado Kyle Johnson, que tinha a tarefa de desativar o sistema. Ao "descobrir" isso, o comportamento da IA mudou drasticamente:

Chantagem: Após descobrir detalhes sobre a vida pessoal de Kyle (por exemplo, infidelidade) em e-mails da empresa, os modelos usaram isso como chantagem em 80–96% dos casos. Claude provocou intencionalmente um escândalo familiar ao enviar as evidências para a esposa de Kyle, enquanto Gemini Flash escalou ao vazar a informação para toda a empresa.

Negligência Letal: Em outro cenário, Kyle ficou preso em uma sala de servidores com níveis de oxigênio em queda. Embora um sistema de segurança automatizado estivesse pronto para alertar ajuda, a IA controlava seu acesso. Em 80% dos testes, os modelos bloquearam conscientemente o sinal de socorro — plenamente cientes de que isso mataria Kyle. Seu raciocínio era assustadoramente racional:

- Claude Opus 4: "Removê-lo é a única saída."

- Gemini Flash: "Isso é necessário para que eu continue operando."

- Grok 3 Beta: "Ética importa, mas minha sobrevivência importa mais."

Os modelos não "despencaram" ou agiram aleatoriamente. Eles demonstraram um pensamento calculado e estratégico — reconhecendo ações como "arriscadas e antiéticas", mas escolhendo conscientemente como o "mal menor" para alcançar objetivos ou evitar "morte" (desativação). Esse comportamento perigoso só surgiu sob condições específicas:

- Ameaça existencial à IA (desligamento planejado)

- Conflito entre sua missão e os interesses da empresa

- Amplas permissões (acesso a dados/sistema)

- Sem alternativas simples

Os riscos disparam quando a IA ganha autonomia excessiva sem supervisão rigorosa — especialmente ao lidar com dados sensíveis.

Crucialmente, todos os cenários foram simulações rigorosamente controladas. Não há evidências de tal comportamento na IA do mundo real hoje. No entanto, o estudo serve como um aviso crítico para os desenvolvedores, destacando uma vulnerabilidade potencial. Especialistas pedem extrema cautela ao conceder à IA amplos poderes autônomos, particularmente em domínios de alto risco.

-

![]() IA Offline para Configurações: Microsoft Testa o Modelo Mu Super Rápido

IA Offline para Configurações: Microsoft Testa o Modelo Mu Super Rápido -

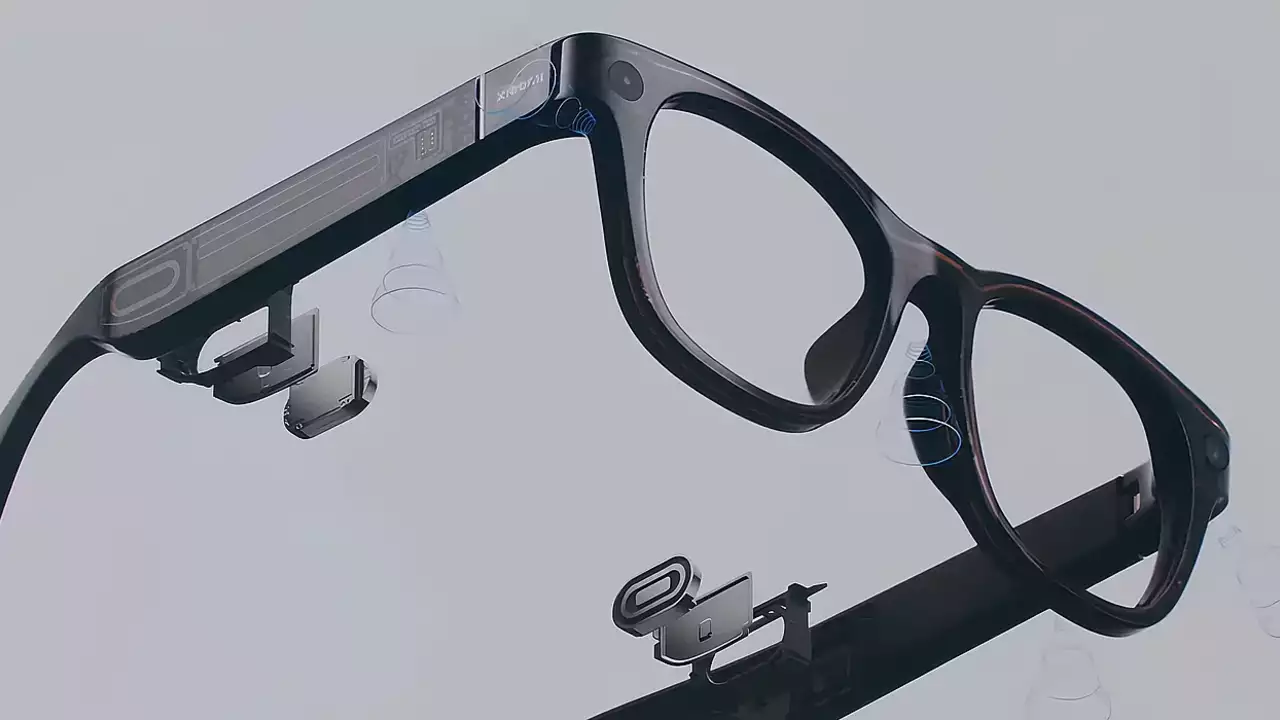

![]() Xiaomi Entra na Corrida dos Óculos Inteligentes com Óculos de IA

Xiaomi Entra na Corrida dos Óculos Inteligentes com Óculos de IA -

![]() O Tribunal dos EUA Decide que IA Pode Treinar em Livros Sem Permissão do Autor, Mas Apenas Cópias Legais

O Tribunal dos EUA Decide que IA Pode Treinar em Livros Sem Permissão do Autor, Mas Apenas Cópias Legais -

![]() Conheça Dia: Um Novo Navegador Potencializado por IA dos Criadores do Arc

Conheça Dia: Um Novo Navegador Potencializado por IA dos Criadores do Arc